OpenStack Nova 的存储管理

2011年09月5日 | 标签: cloud, openstack nova

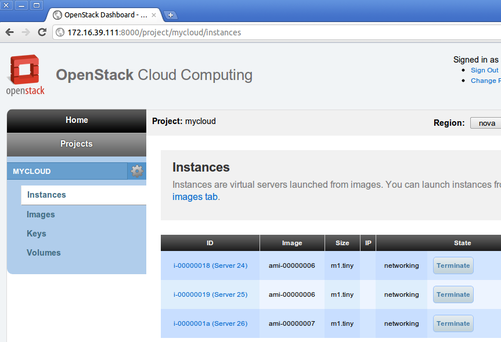

OpenStack Nova 创建出来的 instance 不是所有的类型都有存储的,比如 m1.tiny: Memory: 512MB, VCPUS: 1, Storage: 0GB, FlavorID: 1, Swap: 0MB, RXTX Quota: 0GB, RXTX Cap: 0MB 的存储就是 0,也就是说关闭 m1.tiny 类型的 instance 后所有数据都会丢失。OpenStack Nova 使用 nova-volume 服务来管理存储,可以把这种服务看成云计算时代的 USB,可以随时 attach 到 instance 上做额外存储,其实现和 Amazon 的 Elastic Block Storage (EBS) 不同,nova-volume 提供的是一种基于 Linux LVM 的 iSCSI 解决方案。

Nova-volume 需要一个单独的分区做 LVM,如果系统上没有多余的分区做 LVM 的话可以用一个文件来充当硬盘,当然这种方法只能自己测试玩玩,应用到生产环境最好还是用物理硬盘上的分区做 LVM.

新建一个文件来做 LVM:

# dd if=/dev/zero of=/home/vpsee/nova-volumes.img bs=1M seek=100000 count=0 # losetup -f nova-volumes.img # losetup -a /dev/loop0: [fb00]:24120015 (/home/vpsee/nova-volumes.img) # vgcreate nova-volumes /dev/loop0 No physical volume label read from /dev/loop0 Physical volume "/dev/loop0" successfully created Volume group "nova-volumes" successfully created # pvscan PV /dev/sda5 VG node01 lvm2 [465.52 GiB / 48.00 MiB free] PV /dev/loop0 VG nova-volumes lvm2 [97.65 GiB / 77.65 GiB free] Total: 2 [563.17 GiB] / in use: 2 [563.17 GiB] / in no VG: 0 [0 ]

默认情况下 iscsitarget 软件包安装后并没有自动启动,所以需要手动配置和启动 iscsitarget 服务:

# vi /etc/default/iscsitarget ISCSITARGET_ENABLE=true # service iscsitarget start * Starting iSCSI enterprise target service

新建一个大小为 10GB 的 volume,检查一下是否创建成功(available),并把刚创建的 volume 附加到正在运行的 instance 上,附加成功后再次检查 volume 的状态就变成 in-use 了:

# euca-create-volume -s 10 -z nova VOLUME vol-00000003 10 creating (mycloud, None, None, None) 2011-08-30T13:20:04Z # euca-describe-volumes VOLUME vol-00000003 10 nova available (mycloud, node01, None, None) 2011-08-30T13:20:04Z # euca-describe-instances RESERVATION r-i5927300 mycloud default INSTANCE i-00000031 ami-00000006 172.16.39.224 172.16.39.224 running mykey.priv (mycloud, node01) 0 m1.tiny 2011-08-26T07:12:57Z nova # euca-attach-volume -i i-00000031 -d /dev/vdb vol-00000003 VOLUME vol-00000003 # euca-describe-volumes VOLUME vol-00000003 10 nova in-use (mycloud, node01, i-00000031[node01], /dev/vdb) 2011-08-30T13:20:04Z

如果想从运行的 instance 上卸载 volume 的话用 euca-detach-volume,卸载成功的话就会看到 volume 的状态又变回 available 了:

# euca-detach-volume vol-00000003 VOLUME vol-00000003 # euca-describe-volumes VOLUME vol-00000003 10 nova available (mycloud, node01, None, None) 2011-08-30T13:20:04Z