WebKeepers:$6.95 Virtuozzo VPS

2009年10月17日 | 标签: vps

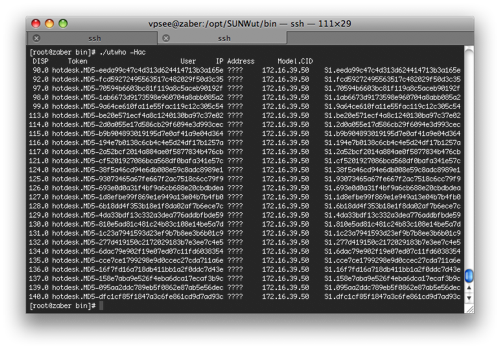

WebKeepers 是 Webk.net 的一个分支,主要做基于 Virtuozzo 的 VPS. whois 域名显示 webkeepers.com 域名是2001年注册的,但是 WebKeeper 的 about us 页面上声称从1997年就开始进入 hosting 行业。VPSee 今天下午偶尔发现 webkeepers.com 不能访问,一个连自己网站都不稳定的 VPS 服务商,很让人怀疑其技术和服务质量。VPS 配置如下:

服务器在 San Jose CA

自制控制面板

10GB 硬盘

256MB Guaranteed RAM,256MB Burstable RAM

500GB 带宽

附带1个 Plesk License

6.95美元