使用 DevStack 快速搭建 OpenStack 实验环境

2012年02月16日 | 标签: devstack, openstack, openstack dashboard

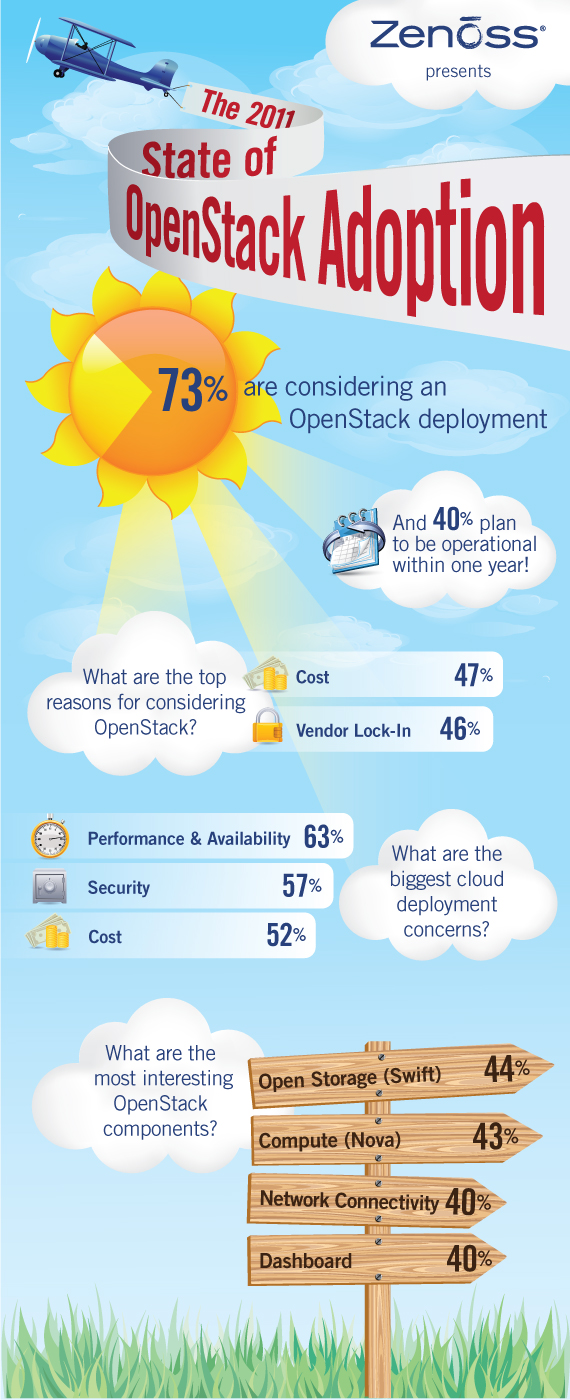

安装 OpenStack 对新手来说是个痛苦的过程,尤其是 OpenStack 和它依赖的一些组件在快速发展中,经常出现这个版本 keystone 对不上那个版本 dashboard 类似的情况。如果只是想看看 OpenStack 的话,使用 DevStack 是个不错的办法。DevStack 实际上是个 shell 脚本,可以用来快速搭建 OpenStack 的运行和开发环境,特别适合 OpenStack 开发者下载最新的 OpenStack 代码后迅速在自己的笔记本上搭建一个开发环境出来。正如 DevStack 官方所强调的,devstack 不适合用在生产环境。

Can I use DevStack for production?

A: No. We mean it. Really. DevStack makes some implementation choices that are not appropriate for production deployments. We warned you!

维护一个支持多 Linux 发行版的脚本需要很多工作,为了保持简单,DevStack 目前只支持 Ubuntu 11.10 发行版。使用 devstack 脚本很简单,安装 git,然后下载 devstack 代码到本地,运行 stack.sh 脚本依次设定 MySQL, RabbitMQ, OpenStack Dashboard 和 Keystone 的密码,密码输入后 stack.sh 脚本会自动开始安装必要的软件包和库并下载最新的 OpenStack 及其组件代码,整个过程自动完成无需干预:

$ sudo apt-get install git $ git clone git://github.com/openstack-dev/devstack.git $ cd devstack/ $ ./stack.sh ################################################################################ ENTER A PASSWORD TO USE FOR MYSQL. ################################################################################ This value will be written to your localrc file so you don't have to enter it again. Use only alphanumeric characters. If you leave this blank, a random default value will be used. Enter a password now: ... horizon is now available at http://192.168.2.240/ keystone is serving at http://192.168.2.240:5000/v2.0/ examples on using novaclient command line is in exercise.sh the default users are: admin and demo the password: vpsee This is your host ip: 192.168.2.240 stack.sh completed in 684 seconds. $

如果对默认的 tty.tgz 镜像不满意,想用 ubuntu 11.10 镜像的话编辑 stack.sh 脚本,在 for image_url in ${IMAGE_URLS//,/ }; do 一行上面加入 IMAGE_URLS=http://uec-images.ubuntu.com/oneiric/current/oneiric-server-cloudimg-amd64.tar.gz 这行,然后重新运行 stack.sh 脚本:

$ vi stack.sh

...

IMAGE_URLS=http://uec-images.ubuntu.com/oneiric/current/oneiric-server-cloudimg-amd64.tar.gz

for image_url in ${IMAGE_URLS//,/ }; do

# Downloads the image (uec ami+aki style), then extracts it.

IMAGE_FNAME=`basename "$image_url"`

if [ ! -f $FILES/$IMAGE_FNAME ]; then

wget -c $image_url -O $FILES/$IMAGE_FNAME

fi

KERNEL=""

RAMDISK=""

...

$ ./stack.sh

还有一点值得注意的地方,如果想使用现有的网络,比如安装 devstack 的这台服务器地址是 192.168.2.240,想让所有运行在上面的 instance 的地址为 192.168.2.241-192.168.2.247 的话,需要修改 stack.sh 里面的 TEST_FLOATING_RANGE,然后重新运行 stack.sh 脚本:

$ vi stack.sh

...

#TEST_FLOATING_RANGE=${TEST_FLOATING_RANGE:-192.168.253.0/29}

TEST_FLOATING_RANGE=${TEST_FLOATING_RANGE:-192.168.2.240/29}

...

$ ./stack.sh

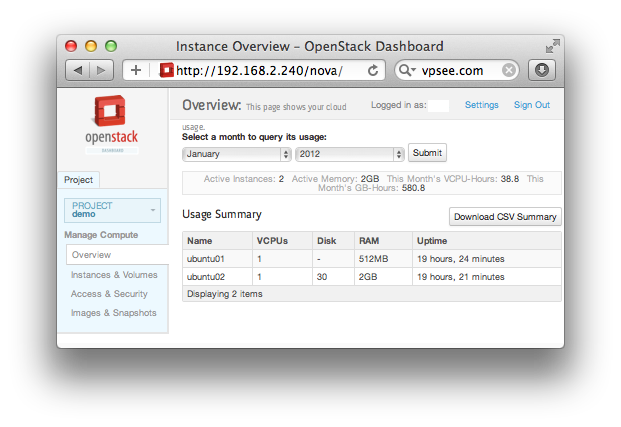

DevStack 安装结束后打开浏览器访问 http://192.168.2.240/ 就可以看到 OpenStack Dashboard 界面,用户名是 admin,密码是刚才设定的密码,输入正确后就会进入 Dashboard,最新的 OpenStack Dashboard 已经有了很大改善,可以创建或导入 keypairs,启动或终止 instance,分配和注射 IP 给 instance,创建和分配 volume 等,还可以添加和管理用户等。界面如下: