在 XenServer 上用 ISO 安装虚拟机

2010年07月13日 | 标签: xencenter, xenserver

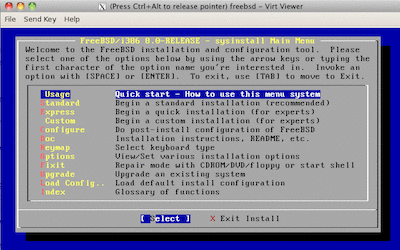

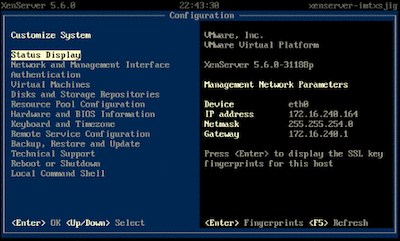

Citrix XenServer 是企业级面向云计算的虚拟平台,有 XenServer, Essentials for XenServer, Enterprise Edition 和 Platinum Edition 三种版本,其中 XenServer 是免费的,和 VMware ESXi 是同级别的竞争产品。XenServer 的安装过程和 VMware ESXi 一样容易,安装完后界面如下。和 VMware ESXi 类似,主要的操作和配置都可以在一个另外一台装有 XenCenter 客户端的机器上完成(和 VMware vShpere Client 一样)。

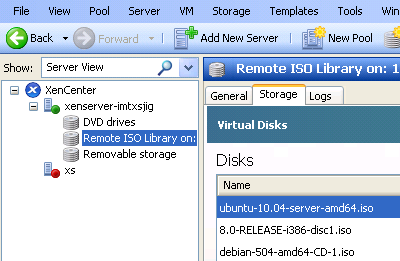

和 VMware ESXi 有点不同的是,XenServer 不能在 XenCenter 客户端管理界面里直接导入 iso 后安装操作系统,需要先把这些 iso 预存到另一台机器上,然后用 NFS 的方式访问。所以我们先在其他的机器开设一个 iso 目录并收集一些 iso 文件,用 NFS 导出这个 iso 目录,然后在 XenServer 服务器上手动把这个目录挂上,这样才能在 XenServer 和 XenCenter 管理界面里看到所有的 iso 文件,也就是说 XenServer 鼓励你把 iso 文件分开存储到另外一台单独服务器以方便管理,对下面的 NFS 操作不清楚的话可以参考 在 CentOS 上安装和配置 NFS 4.0:

# vi /etc/export /home/vpsee/iso 172.16.240.164(rw,sync,no_root_squash) \ 172.16.240.164(rw,sync,no_root_squash) # /etc/init.d/portmap restart # /etc/init.d/nfs restart

在 NFS 服务器上设置权限,允许 XenServer 服务器访问 NFS:

# vi /etc/hosts.deny portmap:ALL # vi /etc/hosts.allow portmap:172.16.240.0/255.255.254.0

用 ssh 登录 XenServer 后挂在 NFS 服务器上的目录:

$ ssh [email protected] [email protected]'s password: # xe-mount-iso-sr 172.16.240.10:/home/vpsee/iso

成功挂载后,在 XenCenter 控制台上(目前 XenCenter 只有 Windows 版本)就可以看到所有的 iso 了:

剩下就好办了,有了 iso 就可以直接安装操作系统了,注意如果机器 CPU 不支持全虚拟(Intel VT 或 AMD SVM)的话会导致安装失败、报错:

xenserver-imtxsji: HVM is required for this operation INVALID_SOURCE - Unable to access a required file in the specified repository: file:///timp/cdrom-repo-RZ1Yem/install.386/xen/vmlinuz.

如果是这样的话就只能通过网络(Install from URL)安装半虚拟系统了。