升级 Red Hat Linux 7.3 到 CentOS 3.1

2012年10月22日 | 标签: centos, redhat, redhat 7.3, vmware vcenter converter

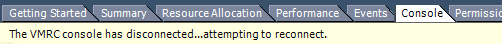

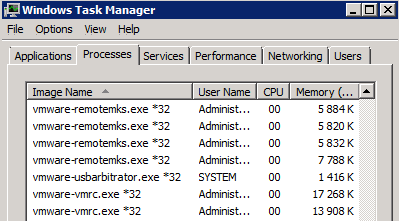

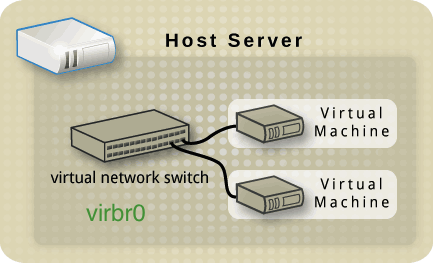

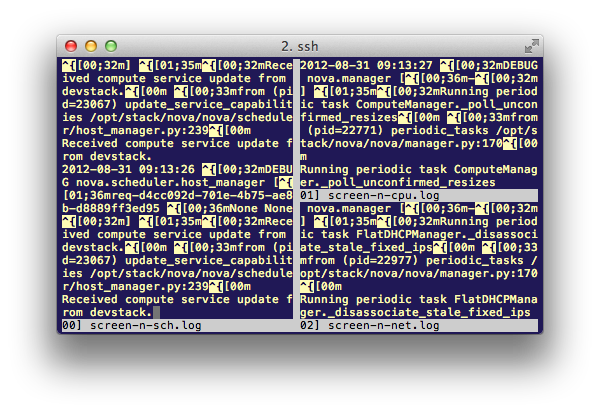

最近用 VMware vCenter Converter 工具企图虚拟化一台很古老的 Red Hat Linux 7.3 物理服务器失败,可能是因为 RedHat 7.3 版本太老 VMware Converter 支持不到位。虚拟化太老的系统如果使用一些自动迁移工具不成功的话可以自己动手迁移,虽然麻烦点,比如做个虚拟硬盘、加上分区表、把文件系统拷贝过去、重置 grub、最后修改几个关键文件等。现在这里的想法是把 RedHat 7.3 升级到 CentOS 3.1 再用 VMware Converter 试一下,如果这样还不成功就只能手动虚拟化物理机了。升级前先备份系统(可用光盘启动后 dd 硬盘到另一个硬盘),防止升级失败后系统启动不了或者升级后关键程序不能运行。升级前不确定 RedHat 7.3 到 CentOS 3.1 这种不同版本、不同版本号的大跨度升级能否成功,有必要纪录一下。

登陆 RedHat 7.3 后安装 yum:

# wget http://ftp.ie.freshrpms.net/pub/freshrpms/redhat/7.3/yum/yum-1.0.3-3.rh.fr.i386.rpm # rpm -ivh yum-1.0.3-3.rh.fr.i386.rpm

编辑 yum.conf 加入 centos 3.1 的源:

# vi /etc/yum.conf [main] cachedir=/var/cache/yum debuglevel=2 logfile=/var/log/yum.log pkgpolicy=newest distroverpkg=redhat-release installonlypkgs=kernel kernel-smp kernel-hugemem kernel-enterprise kernel-debug kernel-uns upported kernel-smp-unsupported kernel-hugemem-unsupported tolerant=1 exactarch=1 [base] name=CentOS-$releasever - Base baseurl=http://centosa3.centos.org/centos-3/3.1/os/i386/ gpgcheck=1 #released updates [update] name=CentOS-$releasever - Updates baseurl=http://centosa3.centos.org/centos-3/3.1//updates/i386/ gpgcheck=1 #packages used/produced in the build but not released [addons] name=CentOS-$releasever - Addons baseurl=http://centosa3.centos.org/centos-3/3.1/addons/i386/ gpgcheck=1 #additional packages that may be useful [extras] name=CentOS-$releasever - Extras baseurl=http://centosa3.centos.org/centos-3/3.1/extras/i386/ gpgcheck=1

升级系统,完成后重启:

# yum update # yum upgrade # shutdown -r now